Wachstumsprobleme in der IT-Branche in den Griff bekommen

10. März 2020

Wachstum ist das Credo heutiger Unternehmen – und macht alle glücklich, ganz besonders die Inhaber. Jedoch geht Wachstum auch mit vielen Herausforderungen einher, insbesondere für die IT.

IT-Umgebungen wachsen im Idealfall „organisch“, also eher kontrolliert und mit mäßiger Geschwindigkeit. Das kann man als gesundes Wachstum bezeichnen und es äußert sich klassisch zum Beispiel durch das Hinzufügen eines neuen Switches in den Stack, weil neue Arbeitsplätze benötigt werden, oder im Erweitern der Database Availability Group der Mail-Anwendung um einen weiteren Server.

Anorganisches Wachstum ist deutlich komplexer. Dieses tritt ein, wenn es zu Fusionen verschiedener Unternehmen, oder Zukäufen beziehungsweise Übernahmen kommt. Derartige Situationen stellen für die Verantwortlichen in der IT nicht selten ernsthafte Probleme dar. Eine explosionsartige Ausweitung der Infrastruktur, in Konkurrenz stehende Inselanwendungen oder gar inkompatible Kommunikationsprotokolle sind deutlich mehr, als die eingangs erwähnte Herausforderungen.

Aber selbst organisches Wachstum ist heute nicht mehr so trivial wie in der Vergangenheit. Denn die IT findet auf mehreren Ebenen statt, ist üblicherweise dezentral, vor allem aber ständig in Bewegung.

Vorteile und Anforderungen der Zukunft

Bei vielen Anwendungen spielt es tatsächlich keine Rolle, ob diese aus dem „Serverraum nebenan“ oder der Cloud betrieben werden. In nicht wenigen Umgebungen weiß man schon gar nicht mehr, wie die Bereitstellung jetzt gerade abläuft, oder sie ist für jemanden im Büro in Berlin komplett anders als für die Kollegen in der Niederlassung in Tokyo. Diese Art von Bereitstellung kommt mit vielen Vorteilen: Neben der – für Wachstum unabdingbaren – Flexibilität, hat sich die Anzahl an kompletten Ausfällen deutlich vermindert, da Hochverfügbarkeit kein Problem mehr darstellt.

Auch Bedrohungssituationen haben sich verändert. Perimeter-Security ist so gut geworden, dass mittlerweile der interne Mitarbeiter ein größeres Risiko darstellt als externe Black Hats. Allerdings verändern sich damit auch Metriken bzw. Anforderungen.

Mittlerweile darf man die gewünschten 99,9 oder 99,99 Prozent Verfügbarkeit – vielleicht auch fünf „Neuner“ – als heutigen Standard betrachten. Aber, wie man so schön sagt: „Slow is the new down“, denn Individuen verlieren viel schneller die Geduld. Wenn ein Kunde zu lange auf die Antwort einer Web-Anwendung warten muss, wechselt er auf ein anderes Portal und ist als solcher für das langsamere Unternehmen verloren.

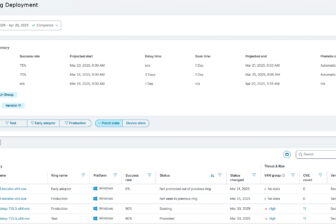

Den Überblick in hybriden Deployments zu bewahren, ist nur noch mit geeigneten dynamischen Visualisierungen möglich, die in der Lage sind, die Beziehungen von Elementen standortübergreifend auf verschiedenen Schichten automatisch zu erkennen, und auf Veränderungen so zeitnah wie möglich zu reagieren.

Unglücklicherweise kann eine solche Anwendung zum Management einer komplexen Umgebung die Komplexität zusätzlich erhöhen anstatt, wie gedacht, zu erleichtern. Jeder Baustein, jede Schicht definiert sich über andere Metriken, nutzt andere Kontrollorgane, muss anders bedient werden. Etablierte Technologien, wie zum Beispiel „ICMP Heartbeats“ zum Feststellen von Verfügbarkeit und Antwortzeit oder dem Abfragen simpler Kennzahlen über SNMP oder WMI, sind bei weitem noch nicht überflüssig, aber stoßen immer öfter auf Grenzen.

Dazu kommt, dass wir schon lange nicht mehr im Zeitalter von homogenen IT-Landschaften leben. Wo man früher nur einen Hersteller eingesetzt hat, um alles aus einer Hand zu haben und an langfristigen Partnerschaften interessiert war, wird heute meist das genommen, was gerade verfügbar ist, die Mindestanforderungen abdeckt, aber vor allem: was ins Budget passt.

Die verschiedenen Hersteller nutzen unterschiedliche APIs zur Kommunikation, Kontrolle und Verwaltung von einzelnen Elementen. Dies ist einer der Nebeneffekte aus dem SDx-Hype der vergangenen Jahre, und eigentlich eine gute Neuigkeit, weil dadurch weitere Türen zu weiterführenden Technologien geöffnet werden.

Doch Kennzahlen aus diesen untereinander inkompatiblen Systemen einzulesen und in Relation zu setzen ist durchaus als hohe Kunst zu bezeichnen, die Technikexperten und deren Werkzeuge schnell an die Grenzen bringen kann. Dazu kommt, dass eine solche Aufgabe auch sehr zeitintensiv ist.

Schlüsselrolle Automatisierung

Wer im Alltag Zeit gewinnen möchte, der sollte Aufgaben delegieren – früher an den Auszubildenden, heute an Automation, morgen an KI. Doch nicht in jeder Organisation, nicht in jeder Situation können komplette Aufgaben „wegautomatisiert“ werden, sicherlich aber einzelne, repetitive Arbeitsschritte. So ist es zum Beispiel nicht mehr notwendig, manuell ein Ticket zu eröffnen, wenn es zu einem Problem mit einer Anwendung kommt. Moderne Systeme zur Kontrolle und für das Troubleshooting lassen sich in populäre ITSM-Lösungen integrieren und helfen dadurch, den manuellen Aufwand, welcher der leider notwendigen Dokumentation geschuldet ist, zu minimieren.

Es ist nicht immer einfach bei immerwährendem Fortschritt in der Technologie am Ball zu bleiben, und Wachstum in Unternehmen macht es nicht einfacher. Trotzdem, oder gerade deswegen, sollte man auch schauen welche Neuigkeiten es bei Monitoring und Management gibt, da die Hersteller dort immer neue Features hinzufügen, die das Leben des IT-Profis deutlich vereinfachen.

Sascha Giese ist Head Geek bei Solarwinds.