User Experience Monitoring-Silos mit KI schließen

13. Juli 2023

Die Verlagerung von Anwendungen und Daten in die Cloud zwingt IT-Teams dazu, ihr Arsenal zur Leistungsüberwachung der Services zu erweitern. Mit Hilfe von Telemetriedaten wollen sie den Überblick über die Dienstleistungsqualität all ihrer Ressourcen in und außerhalb der Cloud erhalten. Das ist umso wichtiger, je mehr sich der traditionelle Arbeitsplatz in hybride Modelle wandelt und Mitarbeitende von überall einen sicheren und performanten Zugriff auf Daten und Kollaborations-Tools fordern.

Der klassische Arbeitsplatz verändert sich rasant. Bereits 33 Prozent der IT-Entscheider in Deutschland gaben in der globalen Studie zum Status der Zero Trust Transformation an, dass ihre Belegschaft vollständig remote arbeiten kann und zusätzliche 28 Prozent zumindest hybride Arbeitsmodelle anbieten. Dementsprechend muss sich die zumindest teilweise von zu Hause oder unterwegs aus arbeitende Belegschaft auf private Wi-Fi-Anbindungen und Equipment verlassen, um direkt auf SaaS- und Cloud-basierte Dienste zuzugreifen, ohne Umwege über die Unternehmensinfrastruktur.

Ein solch flexibles Arbeitsmodell und die Verbreitung von Cloud-basierten Anwendungen setzt die Teams für Netzwerkbetrieb, den Service Desk und die IT-Sicherheit unter Druck. Denn seit User flexible Arbeitsplatzmodelle wahrnehmen, ist das Volumen der Support-Tickets um 35 Prozent in die Höhe geschnellt und auch die Servicekosten pro Ticket haben sich fast um ein Drittel erhöht. Die Problematik besteht darin, dass Geräte-, Netzwerk- und Anwendungsüberwachungs-Tools blinde Flecken zwischen dem Endgerät der User und deren Anwendungen bzw. dem Netzwerkpfad hinterlassen.

Hilfe für IT und Support-Teams

IT-Betriebs- und Service Desk-Teams müssen vielfach die notwendigen Daten zur Leistungsüberwachung der Anwendungsqualität aus unterschiedlichen Tools manuell exportieren und korrelieren, um sich auf die Suche nach Engpässen und schlechter User Experience mit ihren Mitteln zu begeben. Ein solcher Mangel an Ende-zu-Ende-Transparenz der Anbindungsqualität der digitalen User hat Folgen für die IT-Teams. Sie arbeiten reaktiv und können Probleme erst nach deren Meldung durch die Benutzer beheben, anstelle eine vorbeugende Fehlerbehandlung zu betreiben. Die zahlreichen Warnmeldungen unterschiedlichster Tools für die Analyse der Root-Cause von Beschwerden oder Anbindungsproblemen setzen einen zeitaufwändigen Suchprozess in Gang.

Für einen ganzheitlichen Einblick in die User Experience sind für Support-Teams eine Reihe von Metriken hilfreich, die auch von den Geräten von Remote Usern außerhalb des Firmennetzwerks erhoben werden. Dazu zählen Kennwerte zum Gerätestatus wie CPU, Speicher, Batterie, Disk I/O, Netzwerk I/O und Bandbreite oder Wi-Fi-Verbindungsqualität und aktive Prozesse auf der Betriebssystemebene. Auf Prozessebene geben die folgenden Daten Einblick in den Zustand des Endgeräts: Top-Prozesse und Auslastung von CPU, Arbeitsspeicher, Festplatten-I/O, Netzwerk-I/O. Auf Anwendungsebene sind beispielsweise für Kollaborations-Tools Kennzahlen zu Audio-/Video-Qualität, Startzeit, Absturzberichte oder Software-Ereignisse wichtig, um Einblick in die Performance zu geben.

Monitoring-Silos überwinden

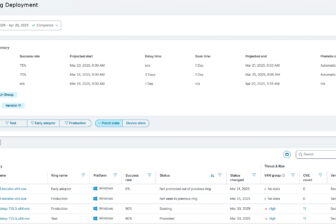

Mit Hilfe von Cloud-basierten Lösungsansätzen, die als Plattformansatz betrieben werden, können die Lücken und blinden Flecken in der Ende-zu-Ende-Ansicht ausgemerzt werden. Lösungen wie Zscaler Digital Experience (ZDX) helfen IT-Teams beim Monitoring der digitalen User Experience aus der Perspektive der Endbenutzer, und tragen dazu bei, die Leistungsqualität zu optimieren und Probleme beim Zugang zu Anwendungen, Netzwerken und Geräten schnell zu beheben.

Da eine Cloud-basierte Plattform zwischen dem User und seiner Anwendung implementiert ist, ist ein solcher Ansatz in der Lage, Einblick in die Benutzererfahrung im gesamten Unternehmen sowie eine End-to-End-Ansicht der Qualität und Verfügbarkeit über die gesamte Anwendungsbereitstellungskette für die IT-Teams unterschiedlicher Abteilungen zur Verfügung zu stellen. Das Monitoring von Telemetriedaten von SaaS-, Public-Cloud- und rechenzentrumsbasierten Anwendungen des Unternehmens direkt von den Endbenutzergeräten aus liefert den IT- und Support-Teams sofortigen Einblick für das Troubleshooting.

Dabei profitieren verschiedenste Teams von der Bereitstellung der Servicequalitätsdaten über eine integrierte Anwenderoberfläche. Netzwerkbetriebsteams können den Zustand der Zugriffspfade überprüfen und Engpässe in allen Unternehmensanwendungen in Echtzeit erkennen. Verschlechterungen in der Servicequalität werden automatisch hervorgehoben und lassen sich beheben, bevor sich User beschweren. Service-Desk-Teams verfügen über eine AI-gestützte Root-Cause-Analyse für jede Benutzerbeschwerde. Dadurch können Probleme schnell kategorisiert werden und lassen sich effizienter ohne aufwändige Fehlersuche lösen.

Gerade in verteilten Arbeitsumgebungen spielt die Überwachung der Qualität von Collaboration-Tools wie Teams, Webex oder Zoom eine entscheidende Rolle, denn sie leisten ihren täglichen Beitrag für die effiziente Zusammenarbeit. Eine Digital Experience Monitoring-Lösung muss deshalb in der Lage sein, die Qualität von MS Teams- und Zoom-Meetings lückenlos zu dokumentieren. Darauf aufbauend lassen sich die Ursachen für schlechte Performance sofort isolieren und unterbrechungsfreie und produktive Meetings gewährleisten. Neben der Erhebung der Live-Meeting-Qualität unter Einbezug verschiedenster Telekommunikations-Provider zeigen Quartalsberichte längerfristiges Optimierungspotenzial auf. IT-Teams erhalten dadurch die Möglichkeit, nicht nur das Tagesgeschäft am Laufen zu halten, sondern können in regelmäßigen Intervallen die Anwendungsqualität überwachen.

Verbesserung der IT-Performanz durch KI

Durch das Digital Experience Monitoring werden in komplexen IT-Umgebungen große Datenmengen generiert. Künstliche Intelligenz (KI) hilft bei der Auswertung dieser Daten und Unternehmensentscheider erhalten wertvolle Erkenntnisse, die zur weiteren Optimierung der IT-Infrastruktur für verteilte Arbeitsumgebungen herangezogen werden können. Die KI leistet dabei in unterschiedlichen Bereichen bereits heute Hilfestellung.

Sie wird beispielsweise für die Ursachenanalyse von Performance-Engpässen eingesetzt. Anstelle der Behebung von kurzfristigen Symptomen, hilft die Untersuchung von langfristigen Datenbeständen dabei, das Kernproblem einer eingeschränkten Benutzererfahrung einzugrenzen und auszumerzen. Darüber hinaus erhalten IT-Teams Einblick, welche Faktoren sich zwischen dem optimalen und dem verschlechterten Benutzererlebnis oder einem festen Zeitpunkt geändert haben.

Sogar dynamische Warnungen lassen sich mit Hilfe integrierter Intelligenz automatisieren. Angesichts der zahlreichen Faktoren, die Auswirkungen auf die Benutzererfahrung haben können, ist es nahezu unmöglich, Warnmeldungen zu erstellen und für jedes Szenario sinnvolle Schwellenwerte festzulegen. Durch die Beobachtung eines normalen Systembetriebs für bestimmte User, Regionen, Anwendungen, Geräte oder Netzwerke kann eine entsprechende Lösung Anomalien automatisch erkennen und präzise Warnmeldungen auslösen. Administratoren müssen dadurch Alarme nicht mehr routinemäßig konfigurieren und pflegen.

Ein Beispiel: Die als normal empfundene Konnektivität in unterschiedlichen Georegionen kann unterschiedlich eingestuft werden. Während der Grundwert in der Verbindungsqualität von einem Mitarbeitenden aus Südafrika unter einem Schwellenwert von dem des Users in Deutschland liegt und völlig normal ist, kann dieser Wert in einer anderen Region bereits ein Alarmsignal sein. Durch den Einsatz von KI können in einem solchen Szenario False Positive-Warnungen ausgeschaltet werden.

Cloud-basiertes Performance Monitoring

80 Prozent der Leistungsprobleme in hybriden Arbeitsumgebungen lassen sich auf Netzwerkprobleme zurückführen. Durch einen Cloud-basierten Ansatz erhalten IT-Teams die Möglichkeit, auch Probleme von remote Usern zu isolieren und zu beheben.

Da die Cloud für Digital Experience Monitoring zum Sammeln von Telemetriedaten zwischen User und Anwendung geschaltet ist, hilft sie bei der Ende-zu-Ende Transparenz zur Performance des gesamten Zugriffspfades und kann die Ursachen für Latenz zuverlässig aufdecken, so dass Mitarbeitende von jedem Arbeitsort aus eine gleichbleibende User Experience genießen.

Simon Lindermann ist Principal Sales Engineer bei Zscaler.