Robuste Datenbankinfrastruktur für den Aufbau von LLMs und generativer KI

3. Juli 2024

KI-Systeme basieren vermehrt auf einer soliden Datenbankinfrastruktur, die für Zuverlässigkeit, Effizienz und Rechenleistung sorgt. Sie benötigen ein Fundament, und dabei geht es um mehr als nur einen Ort für die Datenspeicherung. Es geht darum ein organisiertes, effizientes System zum Verwalten und Verarbeiten enormer Datenmengen zu schaffen.

Die Datenbankinfrastruktur in KI-Projekten zu vernachlässigen kann schwerwiegende Folgen haben – die gesamte Struktur wird dadurch anfällig. Ohne solides Fundament kann die Leistung von KI-Systemen leiden, die Skalierbarkeit sinkt oder sie fallen gar in entscheidenden Momenten aus. Das Ergebnis: ein Vertrauensverlust bei Benutzern. Für komplexe KI-Systeme wie Large Language Models (LLMs) gilt das ganz besonders. Diese Systeme verarbeiten riesige Datensätze für Aufgaben wie Sprachverarbeitung, Bilderkennung und prädiktive Analysen.

Bevor Unternehmen den vollen Nutzen von KI ausschöpfen können, müssen Datenbankexperten und IT-Führungskräfte einiges priorisieren: die Skalierbarkeit, Datenqualität, Performance und Sicherheit der Datenbanken. Erst dann kann man das Potenzial von KI- und Large Language Model-Projekten nutzen.

Skalierbarkeit: Neue Höhen erreichen

Die wachsende Menge von Daten muss von der darunterliegenden Infrastruktur unterstützt werden. Dies erfordert skalierbare Datenbanken, die mit einem Unternehmen mitwachsen und sicherstellen, dass KI-Systeme schnell, sicher und intelligent bleiben – egal wie groß, voneinander abhängig oder komplex sie werden. Zusätzlich zum Speicherplatz müssen Teams die Rechenleistung berücksichtigen. So können Ausfallzeiten verhindert werden, wenn die Datenbank die wachsenden Anforderungen erweiterter KI-Anwendungsfälle verarbeitet.

Um Workloads gleichmäßig im System verteilen zu können, nutzt die KI cloudbasierte Lösungen und strategische Methoden wie Datenindizierung, Sharding und Partitionierung. So wird sichergestellt, dass die Infrastruktur reibungslos mit einem erhöhten Datenbedarf umgehen kann. Gleichzeitig bleibt das KI-System robust und responsiv, Unternehmen vermeiden so Engpässe und Probleme bei der Skalierung.

Beim Cloud Computing gibt es zwei Hauptstrategien zum Erhöhen der Systemkapazität: Hochskalieren (Scaling Up) und horizontales Skalieren (Scaling Out). Scaling Up bedeutet, die Kapazität bestehender Infrastruktur zu erhöhen. Scaling Out entspricht dem Hinzufügen neuer Infrastruktur. Dabei werden Ressourcen wie Server erhöht, um die Kapazität zu erweitern. Beide Methoden sind unverzichtbar für die Entwicklung robuster KI-Systeme, die mit einer wachsenden Nachfrage und Komplexität umgehen können.

Datenqualität: Für unerschütterlich stabile Wände

Daten sind das Rückgrat jedes modernen Unternehmens. Die KI-Performance hängt direkt von der Qualität und Integrität der Daten ab, mit denen sie trainiert wird. Daher müssen Unternehmen ihre Datenbanken kontinuierlich aktualisieren und pflegen, um sie vollständig, einheitlich und aktuell zu halten.

Die Datenbanken, die KI zugrunde liegen, benötigen eine ständige Aufmerksamkeit. Um sicherzustellen, dass die Datenbanken auf dem aktuellen Stand sind, sollten Teams ihre Datenbanken fortlaufend aktualisieren. Dazu gehört, die Daten auf Korrektheit zu prüfen und sie zu bereinigen, um Fehler zu vermeiden. So können Unternehmen sicherstellen, dass ihre Systeme auch bei Herausforderungen stabil bleiben und durchgehend korrekte und verlässliche Ergebnisse liefern.

Leistungsoptimierung: Damit die Lichter nicht ausgehen

Kritische Datenbanken sollten nicht sich selbst überlassen werden. Sie müssen stetig evaluiert und verbessert werden. Nur so bleiben die Daten relevant und effizient. Die Verschlechterung von Datenbanken kann zu einer geringeren Genauigkeit, langsameren Antwortzeiten und Problemen beim Umgang mit neuen Bedrohungen führen. Dafür nutzen KI-Architekten die Abfrageoptimierung und Catching, damit Systeme wie gewünscht funktionieren.

Die Systeme müssen unabhängig von äußeren Bedingungen Daten effektiv verarbeiten und analysieren. Das Datenbank-Monitoring hilft beim proaktiven Erkennen und Beheben von langsamen Abfragen die KI-Projekte behindern könnten. Das gilt auch bei Ressourcenengpässen und unerwarteten Datenbankverhaltensweisen.

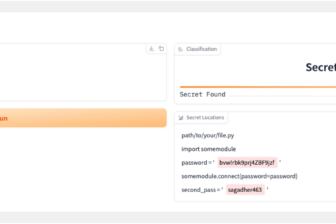

Sicherheitsmaßnahmen: Das Fundament für Vertrauen

Cyber-Sicherheitsprotokolle sind unerlässlich für den Schutz der sensiblen Daten eines Unternehmens. Cyber-Sicherheitsprotokolle wie Secure by Design-Prinzipien und die Multi-Faktor-Authentifizierung spielen eine entscheidende Rolle beim Sicherstellen der Datenintegrität in Unternehmen.

In einer Welt, in der Daten so wertvoll sind, muss der Datenschutz gewährleistet werden. Die Sicherheit ist nicht nur eine technische Anforderung für KI-Systeme. Hierauf fundiert das Vertrauen, dass ethische Standards eingehalten und Innovationen vorangebracht werden. Auf gewisse Weise sind diese Sicherheitsmaßnahmen grundlegend – sie helfen nicht nur KI-Systemen bei Aufgaben, sondern schützen auch die Interessen und Daten der Teams, denen sie dienen.

Datenbankteams können für die Sicherheit ihrer KI-Systeme sorgen, indem sie regelmäßige Sicherheits-Audits durchführen, um potenzielle Schwachstellen zu identifizieren und zu beheben. Indem sie die Sicherheit auf jeder Ebene ihrer Infrastruktur priorisieren – vom Monitoring bis hin zur Wartung und alles dazwischen – können Unternehmen sicherstellen, dass ihre KI-Systeme vertrauenswürdige Aufbewahrungsorte für wertvolle Daten sind.

Wenn Entwickler und Benutzer der Sicherheit von KI-Systemen vertrauen, erhöht sich die Wahrscheinlichkeit, dass sie experimentieren und die Grenzen der Leistungsfähigkeit der Technologien austesten. Genau dieses kritische Fundament muss sorgfältig und vorausschauend ausgebaut werden. So kann sichergestellt werden, dass KI-Systeme zuverlässig und effizient bleiben und ihr volles Potenzial ausschöpfen können.

Krishna Sai