Hyperkonvergenz löst Probleme bei der Zweigstellenanbindung

8. Juli 2015

Viele Unternehmen mit Zweigstellen sind heutzutage mit einer nicht mehr zeitgemäßen IT-Infrastruktur ausgestattet. Aufgrund des hohen Virtualisierungsgrads moderner IT-Umgebungen passen die älteren Konzepte nicht mehr so recht zu den modernen Anforderungen. Vielfach werden noch IT-Umgebungen eingesetzt, die auf eigenständigen Server-, Storage- und Netzwerkplattformen und den zugehörigen Hochverfügbarkeitskonzepten basieren. Doch daraus ergeben sich einige Probleme.

Wer „schnell mal“ ein neues Büro zur Infrastruktur hinzufügen muss, wer neue Anwendungen bereitstellen soll und wer aktuellen Datenschutzaufgaben zu entsprechen hat, der sieht sich vor eine große Herausforderung gestellt. Denn in den bestehenden IT-Infrastrukturen sind die verschiedenen Bereiche – Server, Storage, Netzwerk und Datenschutz – immer separat anzugehen. Zudem gibt es kaum Verwaltungs-Tools, die das Management der Umgebung von einer zentralen Stelle her erlauben. In der Regel stehen in den Zweigstellen und kleineren Büros (Stichwort Home Office) auch keine fachlich versierten IT-Betreuer zur Verfügung – das erschwert die Arbeiten an der Infrastruktur besonders.

Ein zusätzliches Problem ergibt sich aus der vergleichsweise langsamen Anbindung der Zweigstellen an das Hauptquartier. Wenn höhere Bandbreiten zur Verfügung stehen, so sind sie immer noch recht teuer. Daher ist das Thema Datenkompression bei der Zweigstellenanbindung ein wichtiger Faktor.

Mit einer vollständigen Hyperkonvergenz-Architektur lassen sich die IT-Umgebungen in Zweigstellen elegant an die Zentrale anbinden. Dabei reduziert sich der Aufwand in den einzelnen Standorten – und die meisten Verwaltungsaufgaben sind von der Zentrale aus zu erledigen. Simplivity hat dazu ein Konzept vorgestellt, das sich über den Federation-Ansatz seiner Omnicube-Systeme sogar für weltweit verteilte Konzerne eignet.

Die verteilte Natur vieler Unternehmen und der Zwang zur Digitalisierung des Business erfordert eine passende Ausstattung der Zweigstellen in Bezug auf die IT-Umgebung. Eine Zentrale und weltweit verteilte Niederlassungen sind kein Kennzeichen, das nur mehr für große Konzerne zutrifft. Bereits im Mittelstand sind entsprechende Konstrukte zu finden – vor allem wenn Produktionsstandorte in „günstigere“ Regionen ausgelagert wurden.

In diesen Niederlassungen muss das Design der IT-Umgebung komplett anders aussehen, wie das in der Firmenzentrale der Fall ist. Üblicherweise gibt es in der Zweigstelle kein Rechenzentrum – meist ist nur ein Serverraum vorhanden oder das Equipment steht womöglich in einer Ecke in einem Keller. Ganz zu schweigen von den anderen Umgebungsbedingungen: Die Stromversorgung ist – speziell bei Standorten in weniger hoch entwickelten Ländern – nicht so sicher wie hierzulande, an die Kühlung werden höhere Ansprüche gestellt, ebenso muss die relative Luftfeuchtigkeit berücksichtigt werden.

Wenn es in einer Zweigstelle schlechtere Umgebungsparameter für die IT gibt, muss man vielfach dazu übergehen, auch entsprechend weniger IT-Umgebung dort vorzusehen. Daher sollten die IT-Geräte in der Zweigstelle möglichst kompakt konzipiert sein – sprich sie müssen größtmögliche Leistungsfähigkeit auf kleinen Raum/Strom-Bedarf bieten. Eine traditionelle Konfiguration mit Server- Storage- und Netzwerksystemen erweist sich dabei oft nicht als die optimale Wahl.

Ein weiterer Aspekt ist das Thema System- und Netzwerkverwaltung in den Zweigstellen. Was im Rechenzentrum noch von IT-Spezialisten abgedeckt wird, für das steht in den Zweigstellen vielfach kein kompetentes Personal zur Verfügung. Erschwert wird diese Problematik auch durch die verschiedenen Tools: Server- Storage- und Netzwerkhersteller sowie die Anbieter von Virtualisierungslösungen haben alle verschiedene Werkzeige, um ihre Systeme zu verwalten. Daher muss quasi für jede Produktlinie ein eigener Spezialist verfügbar sein.

Das kann im Rechenzentrum noch funktionieren – auch wenn es für viele Unternehmen auch dort schon eine große Herausforderung darstellt – doch in den Zweigstellen wird man an derartiger Komplexität schnell scheitern. Der Ausweg über Remote-Tools (also Fernwartung), um diese Aufgaben aus der Zentrale heraus zu übernehmen, ist auch nicht immer ein passender Ansatz. Denn in einem Fehlerfall kann es auch dazu kommen, dass die gesamte Zweigstelle nicht mehr an das Firmennetz angebunden ist – dann ist guter Rat teuer. Denn Spezialisten müssen entweder von dritter Seite eingekauft werden oder aber die eigenen Mitarbeiter müssen aus der Zentrale anreisen – Folge: Die IT-Umgebung in der Zweigstelle fällt für eine längere Zeit aus.

Eine weitere Schwachstelle ist zu verzeichnen, wenn die IT-Umgebungen in den Zweigstellen hochverfügbar sein müssen. Hier sind Services nötig wie Backup/Restore oder komplette Disaster-Recovery-Lösungen. Derartige Dienste hängen sehr stark von der Verfügbarkeit und der Bandbreite der WAN-Strecke ab. Üblicherweise besitzen Zweigstellen eine Anbindung an das Internet, um den Email-Verkehr und das Browsen im WWW in der Zweigstelle zu ermöglichen. Über dieses Netzwerk greifen aber in den meisten Fällen auch die Backend-Systeme in der Zweigstelle (wie etwa Server und die Storage-Arrays) auf die Außenwelt zu.

Für das Backup aber auch für die Kommunikation mit den Systemen in der Firmenzentrale sind funktionierende Infrastrukturdienste in der Zweigstelle nötig, wie etwa das DNS (Domain Name System) oder das AD (Active Directory). Damit diese Dienste über genügend Bandbreite verfügen, müssen in der Zweigstellen meistens Datenreduzierungstechniken zum Einsatz kommen – es geht dabei um WAN Optimizer oder Deduplizierungs-Systeme. Doch das zieht erneut Kosten und Aufwand bei der Verwaltung dieser Geräte nach sich.

Ein gängiges Konzept, um Hochverfügbarkeit in den Zweigstellen zu garantieren, lautet: Alle Informationen werden an eine zentrale Stelle – oftmals das Rechenzentrum in der Zentrale oder ein regionales Rechenzentrum – repliziert. Wenn ein Unternehmen über sehr viele Zweigstellen (weltweit verteilt) verfügt, müssen mehrstufige Architekturen herhalten. Dabei werden sogenannte Hubs eingesetzt, die – jeder für sich – einen Teil der Zweigstellen „konsolidieren“ und von denen dann erste die aggregierten Informationen an das Rechenzentrum in der Zentrale weitergereicht werden. In diesen mehrstufigen Abläufen werden die zu replizierenden Daten mehrmals „angefasst“ und auch mehrmals gespeichert. Damit kann der Speicherbedarf dramatisch ansteigen und es kommt zu einem gewaltigen „Data Problem“.

Doch nicht allein der exponentielle Anstieg der Datenvolumina trägt dazu bei, es kommen noch weitere Aspekte dazu: Es geht um die Verwaltung der Daten, um ihre Mobilität, den Schutz der Daten und die Zugriffsgeschwindigkeit auf die Daten. Daher reicht es nicht mehr, Daten „einfach abzulegen“. Vor allem in virtuellen Umgebungen müssen die Daten extrem mobil sein und verschoben werden können.

Dazu kommt noch die Anforderung, dass die Daten den betreffenden virtuellen Maschinen – und somit auch den verschiedenen Applikationen – zugeordnet sein müssen. Dabei empfiehlt es sich, dass alle Aktionen auf die Daten möglichst automatisiert abgewickelt werden und von entsprechenden Richtlinien (den sogenannten Policies) förmlich gesteuert werden.

Eine weitere Komplexität ergibt sich aus den Sicherheitsanforderungen für die Daten: Sie sind zum einen über ein lokales Backup gegen Verlust zu sichern, und zum anderen erweist sich eine Offsite-Speicherung als sinnvoll, etwa um Disaster Recovery-Ansätze zu erfüllen. Generell gilt: Die Daten müssen immer verfügbar sein, es darf nie zu einem Datenverlust kommen. Das wird heutzutage über die SLAs (Service Level Agreements) abgewickelt. Unternehmen geben an, welchen Grad von SLA sie für bestimmte Daten benötigen. Vor allem für unternehmenskritische Informationen sind hohe Ansprüche üblich. Dabei beziehen sich die Anforderungen sowohl auf die Daten in der Zentrale, als auch in den verschiedenen Zweigstellen eines Unternehmens.Wenn es darum geht, eine optimale IT-Infrastruktur für eine Zweigstelle zu definieren, sind einige Faktoren gefragt:

- Speicher: Da heutzutage überwiegend Servervirtualisierung zum Einsatz kommt, muss ein gemeinsamer Speicher für alle Hosts (in vielen Fällen sind das auf VMware ESXi basierende Systeme) angeschafft werden. Dabei wird meist auf NAS- oder SAN-Storage zurückgegriffen.

- Hochverfügbarkeit/Datensicherheit: Wenn die Dienste in der Zweigstelle ausfallen, kann auf die Systeme nicht mehr zugegriffen werden. Die Wiederherstellung der Betriebsbereitschaft muss möglichst schnell machbar sein, denn sonst fällt der komplette Betrieb in der Zweigstelle aus. Daher müssen die Daten möglichst immer im Zugriff bleiben

- Umgebungsparameter: Genügend Platz für die IT und die notwendige Stromversorgung plus Kühlung gilt es auch in der Zweigstelle sicherzustellen. Passt hier der Zuschnitt nicht (etwa an besonders heißen Tagen), ist ein Ausfall der IT in der Zweigstelle zu befürchten.

- Know-how: Wenn IT-Equipment verwaltet sein muss, ist fachliches Know-how nötig. Dazu sind entsprechend qualifizierte Administratoren in der Zweigstelle nötig. Bei kritischen Vorfällen sollten sie Herr der Lage bleiben und die Verfügbarkeit der Dienste sicherstellen oder sie zumindest wieder schnell ans Laufen bringen können.

Sieht man sich heutige Lösungen für dieses Zweigstellenszenario an, erkennt man schnell: Die Servervirtualisierung hat viele Probleme erleichtert bzw. ganz gelöst. Doch bei den Storage-Systemen sieht das in vielen Fällen anders aus. Auch wenn eine Applikation – die üblicherweise in einer virtuellen Maschine betrieben wird – schnell wieder gestartet werden kann, so bleiben die Daten, mit denen die Applikation hantiert, doch im Storage Array „gefangen“ (wo die Zuweisung immer noch über die LUNs erfolgt). Damit wird das Bereitstellen der Daten für eine flexible – weil virtualisierte – Infrastruktur immer noch ein sehr aufwändiges und somit auch teures Unterfangen.

An diesem Punkt setzen die hyperkonvergenten Infrastrukturen an. Darunter versteht man Systeme, die eine Virtualisierung von Server-, Storage und Netzwerkdiensten in einer Appliance bereitstellen. Natürlich muss dazu auch das Management dieser Funktionsblöcke aus einem Guss bereitgestellt werden. Mit einer derartigen Lösung lassen sich auch deutliche Kostenvorteile erzielen.

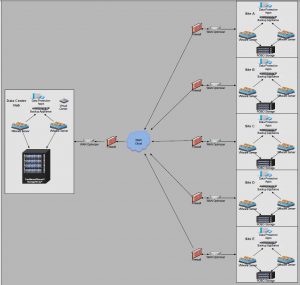

Eine typische IT-Architektur für eine – nicht allzu kleine – Zweigstelle eines Unternehmens ist in Bild 1 gezeigt. Sie besteht aus den folgenden Elementen:

- Storage: Ein gemeinsames Speichersystem garantiert eine hohe Verfügbarkeit sowie die notwendige Leistungsfähigkeit der Festplattenlaufwerke.

- WAN-Optimizer: Um die Bandbriete der WAN-Strecke bestmöglich auszunutzen, müssen zuerst alle redundanten Daten eliminiert (Datendeduplizierung) und das Zwischenspeichern der Daten erfolgen – erst dann sollte die Übertragung der Daten über die WAN-Strecke erfolgen.

- Virtuelle Server: Der Umstieg in die Servervirtualisierung reduziert die Anzahl der physischen Server in der Zweigstelle. Virtuelle Maschinen können dann auch viel schneller von einem Host zum anderen umziehen – dabei wird der Betrieb der Applikation in der VM üblicherweise sogar sichergestellt.

- Backup Appliances und Datensicherung: Um entweder lokale Sicherungen oder entfernte Sicherungen in der Zentrale ausführen zu können müssen die entsprechenden Lösungen – einschließlich eines Sicherungs- und Wiederherstellungsplans implementiert sein. Damit soll der Ausfall eines Standorts, eines Systems oder auch nur einer virtuellen Maschine keinen großen Schaden anrichten können. Hierzu wird auch Software für die Datenreplikation verwendet oder entsprechende Appliances eingesetzt.

Wer diesen Aufwand reduzieren möchte, der kann eine Lösung wählen, die auf Hyperkonvergenz-Elementen wie etwa den Omnicube-Appliances von Simplivity basiert. Bei diesen Systemen sind die wesentlichen Funktionalitäten kombiniert: Server inklusive der Servervirtualisierung, Storage, Backup/Recovery inklusive Disaster Recovery, WAN-Optimizer und weitere Funktionen wie Datendeduplizierung, Datenkompression gehören dazu. Verwaltet wird diese Lösung mit vCenter von VMware. Damit lassen sich alle Zweigstellen von der Zentrale aus administrieren.

Generell setzt die IT-Architektur mit Omnicube auf einer sternförmigen-Architektur (auch als Speichenarchitektur bezeichnet) auf. In der Zentrale wird sozusagen als Mittelpunkt ein Paar von Omnicube-Appliances platziert. Diese beiden Systeme garantieren zum einen eine hohe Ausfallsicherheit – es gibt keinen Single Point of Failure. Sie agieren zudem als Ziele für die Sicherung der entfernten Systeme (in den Zweigstellen). An jedem Standort kann das Unternehmen dann ebenfalls zwei (oder bei kleinen Konfigurationen auch nur eine Omnicube-Appliance, in diesem Fall wird auf eine besonders hohe Ausfallsicherheit verzichtet) Appliances einsetzen (siehe Bild 2).

Lokale Sicherungsrichtlinien sind so zu setzen, dass die Daten auch im entfernten Standort vorliegen. Das remote Backup – also von der Zweigstelle werden die Daten auch in die Zentrale gesichert – sind dann noch so einzustellen, dass die Vorgaben an die Wiederherstellungszeiträume für die Daten in der Zweigstelle erfüllt werden. Alle Daten, die in der Zweigstelle anfallen werden inline komprimiert und/oder dedupliziert. Das erfolgt beim Omnicube in Echtzeit. Somit werden auch alle Datenübertragungen aufgrund des Backups zur oder von der Zentrale entsprechend optimiert. Das reduziert die Transferdauer und den Bandbreitenbedarf für die Verbindung von Zweigstelle zur Zentrale.

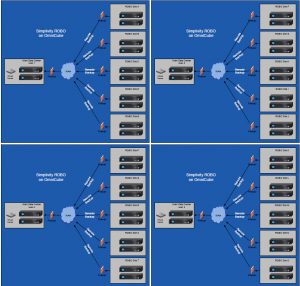

Für sehr umfangreiche IT-Infrastrukturen, die womöglich sogar die komplette Welt umspannen sollen, reicht der bisher geschilderte Ansatz nicht aus. In derartigen Konfigurationen muss auf eine „Multi Federation Architecture“ zurückgegriffen werden (Bild 3). Dabei wird das Prinzip beibehalten, allerdings wird eine Zwischenschicht eingezogen. Hier erweist sich das Federation-Konzept des Omnicube als vorteilhaft. Denn darüber können entsprechend viele Teilblöcke konsolidiert werden.