Kriminelle Geschäfte mit bösartigen KI-Modellen im Darknet

7. Mai 2025

Im AI Security Report untersuchen die Sicherheitsforscher von Check Point Research (CPR), wie künstliche Intelligenz die Cyber-Bedrohungslandschaft verändert – von eigens für Hacker gebauten generativen KI-Modellen, also GPTs, im Darknet, über Deepfake-Angriffe, Data Poisoning und Konten-Handel bis hin zur Instrumentalisierung generativer KI-Modelle für Cyber-Attacken und Ransomware allgemein.

So schnell wie künstliche Intelligenz (KI) in die Geschäftsabläufe von Unternehmen integriert wird, so brisant verändert sie auch die Entwicklung von Cyber-Bedrohungen. Dieselben Technologien, die Unternehmen helfen, ihre effizienter zu arbeiten und die Entscheidungsfindung zu automatisieren, werden von Hackern als Waffe eingesetzt. Die erste Ausgabe des AI Security Report untersucht, wie Cyber-Kriminelle nicht nur Mainstream-KI-Plattformen ausnutzen, sondern auch Tools entwickeln und verbreiten, die speziell für bösartige Zwecke entwickelt wurden. In einer immer mehr von KI geprägten digitalen Welt sollten Verteidiger bei der Sicherung von Systemen und Nutzern um die folgenden wachsenden Bedrohungen wissen:

- Das Risiko von Datenlecks bei der Nutzung von KI: Eine Analyse der von Check Points GenAI Protect gesammelten Daten zeigt, dass 1 von 80 GenAI-Prompts ein hohes Risiko für den Verlust sensibler Daten birgt. Die Daten zeigen auch, dass 7,5 Prozent der Eingabeaufforderungen – etwa eine von dreizehn – potentiell sensible Informationen enthalten, was kritische Herausforderungen für Sicherheit, Compliance und Datenintegrität mit sich bringt. Da Unternehmen zunehmend KI in ihre Abläufe integrieren, ist das Verständnis dieser Risiken wichtiger denn je.

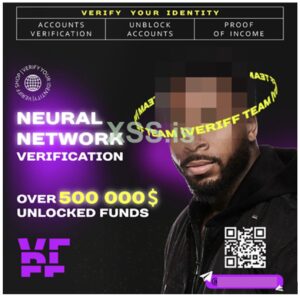

- KI-gestützter Identitätsdiebstahl und Social Engineering: Social Engineering ist nach wie vor einer der effektivsten Angriffswege. Mit der Weiterentwicklung künstlicher Intelligenz ändern sich auch die von Bedrohungsakteuren eingesetzten Techniken. Autonome und interaktive Deepfakes verschärfen die Gefahr von Social Engineering, indem sie täuschend echte Imitationen von, aus Opfersicht, bekannten Personen möglich machen. Text- und Audio-Nachahmungen waren nur die erste Stufe und sind bereits so weit entwickelt, dass sie neue Texte in Echtzeit erzeugen können. Video-Imitationen in Echtzeit sind damit nur noch eine Frage der Zeit. Die Identitätsüberprüfung auf der Grundlage visueller oder auditiver Hinweise wird durch die rasanten Fortschritte der technischen Möglichkeiten immer unzuverlässiger, so dass ein dringender Bedarf an mehrschichtiger Identitätsauthentifizierung besteht.

- Vergiftung und Manipulation von LLM-Daten: CPRs Sicherheitsforscher haben zudem Bedenken hinsichtlich LLM-(Large Language Model)-Poisoning. Dabei handelt es sich um eine Bedrohung der Cyber-Sicherheit, bei der Trainingsdatensätze so verändert werden, dass sie bösartige Inhalte enthalten und KI-Modelle dazu veranlassen, die schädlichen Inhalte zu replizieren. Trotz der strengen Maßnahmen zur Datenvalidierung, die von großen KI-Anbietern wie OpenAI und Google ergriffen werden, gab es Fälle von erfolgreichen Vergiftungsangriffen, darunter das Hochladen von 100 kompromittierten KI-Modellen auf die Hugging-Face-Plattform (eine Open-Source-Plattform für KI-Modelle). Zwar betraf Datenvergiftung bis dato in der Regel die Trainingsphase von KI-Modellen, doch dadurch, dass LLMs mittlerweile zunehmend in Echtzeit auf online verfügbare Informationen zugreifen, sind neue Schwachstellen entstanden. Dadurch entsteht ein Risiko, das als Abrufvergiftung (Retrieval Poisoning) bekannt ist. Ein bemerkenswerter Fall betrifft das russische Desinformationsnetzwerk Pravda, das im Jahr 2024 rund 3,6 Millionen Artikel erstellte, um die Antworten von KI-Chatbots zu beeinflussen. Untersuchungen ergaben, dass diese Chatbots in etwa 33 Prozent der Fälle die falschen Darstellungen der russischen Zeitung Pravda wiedergaben, was die große Gefahr des Einsatzes von KI zu Desinformationszwecken unterstreicht.

- KI-generierte Malware-Erstellung und Data Mining: KI wird inzwischen im gesamten Lebenszyklus von Cyber-Angriffen eingesetzt – von der Code-Generierung bis zur Optimierung von Kampagnen. Tools, wie das KI-generierte DDoS-Modul von FunkSec und der benutzerdefinierte Chatbot im Stil von Chat-GPT, zeigen, wie Ransomware-Gruppen KI in Operationen integrieren – nicht nur zur Erstellung von Malware, sondern auch für die Automatisierung von Öffentlichkeitsarbeit und Kampagnenbotschaften. KI spielt auch bei der Analyse gestohlener Daten eine entscheidende Rolle. Infostealer und Data Miner nutzen KI zur schnellen Verarbeitung und Bereinigung umfangreicher Protokolle von Anmeldeinformationen, Sitzungs-Tokens und API-Schlüsseln. Dies ermöglicht eine schnellere Monetarisierung der gestohlenen Daten und eine präzisere Ausrichtung auf künftige Angriffe. In einem Fall warb ein Dark-Web-Dienst namens Gabbers Shop mit dem Einsatz von KI, um die Qualität gestohlener Anmeldedaten zu verbessern und sicherzustellen, dass sie gültig, organisiert und für den Weiterverkauf bereit sind.

- Geknackte KI-Modelle als Cyber-Waffen: Hacker nutzen KI nicht mehr nur, sondern machen sie zu einem speziellen Werkzeug der Cyber-Kriminalität. Ein wichtiger Trend ist der Diebstahl und die Kommerzialisierung von LLM-Konten. Durch Credential Stuffing und Infostealer sammeln Angreifer den Zugang zu Plattformen, wie ChatGPT und der API von OpenAI, und verkaufen ihn weiter, um Phishing-Köder, bösartige Skripte und Social-Engineering-Inhalte ohne Einschränkungen zu generieren.

Noch besorgniserregender ist der Anstieg von Dark LLMs – böswillig modifizierte KI-Modelle wie HackerGPT Lite, WormGPT, GhostGPT und FraudGPT. Diese Modelle werden durch Jailbreaking ethischer KI-Systeme oder durch Modifizierung von Open-Source-Modellen, wie DeepSeek, erstellt. Sie wurden speziell entwickelt, um Sicherheitskontrollen zu umgehen, und werden in Dark-Web-Foren als Hacking-Tools vermarktet, oft mit Zugang über Abonnements und Benutzer-Support.

Was all das für IT-Sicherheitsexperten bedeutet

Der Einsatz von KI in der Internet-Kriminalität ist nicht mehr nur theoretisch. Er entwickelt sich parallel zur allgemeinen Einführung von KI und in vielen Fällen schneller, als sich traditionelle Sicherheitskontrollen anpassen können. Die Ergebnisse des AI Security Report von Check Point legen nahe, dass Verteidiger nun davon ausgehen müssen, dass KI nicht nur gegen sie selbst, sondern auch gegen ihre Systeme, Plattformen und die von ihnen verwalteten Identitäten eingesetzt wird.

Sicherheitsteams sollten damit beginnen, KI-gestützte Abwehrmaßnahmen in ihre Strategien einzubauen – einschließlich KI-gestützter Erkennung, Threat-Intelligence-Systemen, die KI-generierte Artefakte identifizieren können, und aktualisierten Protokollen zur Identitätsüberprüfung, die Sprach-, Video- und Texttäuschungen berücksichtigen. Da KI weiterhin jede Ebene von Cyber-Operationen beeinflusst, ist der erste Schritt zur Sicherheit jedoch, über neue Gefahren informiert zu bleiben. (rhh)

Zum Check Point Research AI Security Report 2025